Últimamente hay mucho ruido con el tema de CTR y su impacto en el SEO, que si manipular el CTR funciona, que parece que funciona o simplemente no funciona…

Para los neófitos, el CTR (Click-through rate) en SEO es un ratio que mide la eficacia de un resultado en la página de resultados de Google (SERP). Es la división de las veces que se clica un resultado entre las veces que aparece (impresiones). Este porcentaje puede ser consultado fácilmente en el informe de «análisis de búsqueda» de Search Console (antiguo Google Webmaster Tools)

Cuando los resultados de un experimento no son reproducibles es porque el experimento está mal hecho o la hipótesis es errónea. Con lo cual el resultado no es conmensurable, o lo que es lo mismo, no puedes dar por válida la hipótesis que quieres demostrar (en este caso si el CTR afecta o no en los rankings). Pero además en el mundo del SEO tenemos el handicap de la volatilidad del universo en el que se experimenta, donde no podemos aislar todas las variables.

Como consecuencia de la malinterpretación de esta serie de experimentos y otros que llevan tiempo haciéndose han surgido 2 vertientes:

- Los que dicen que Google no tiene en cuenta el CTR en sus algoritmos de ranking.

- Los que dicen que sí se tiene en cuenta y que se puede manipular con bots u otras hierbas.

El CTR es necesario para Google

El CTR junto con otras métricas de comportamiento del usuario (muy bien explicadas por Dan Petrovic en Moz), son las que Google y otros buscadores utilizan para aprender y mejorar resultados (machine learning).

Son métricas con las que los buscadores reciben feedback de cuáles son los resultados que resuelven las necesidades de los usuarios (a priori en la SERP). Un sitio puede estar muy bien a nivel on-page y/o tener una autoridad por razones X, pero puede no dar la respuesta que necesitan los usuarios.

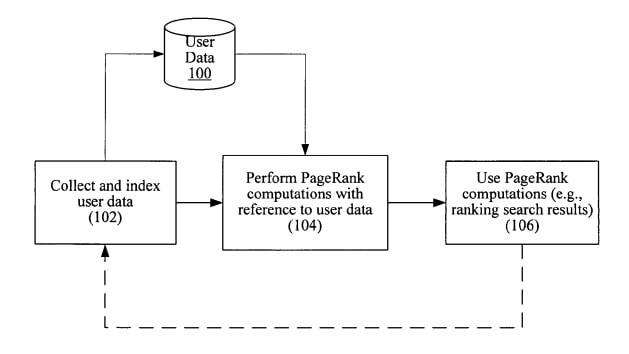

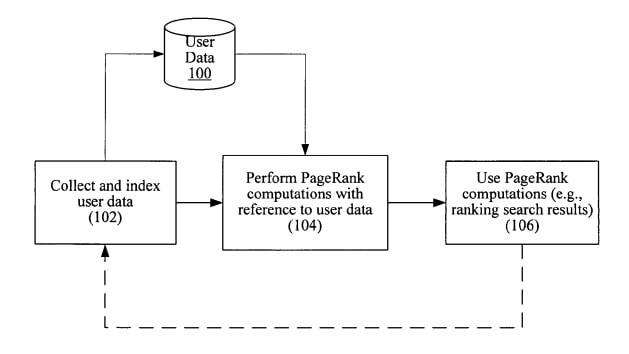

Como comenta Ricardo Baeza (Yahoo) en el capítulo Web Retrieval de su libro Modern Information Retrieval (libro que te tienes que leer si eres SEO), los datos de Click-through son incluso mejores que el Page Rank para determinar la calidad de un resultado. También es la mejor métrica para evaluar la efectividad de un algoritmo cuando se testea. Hasta el punto que hay una patente de Yahoo que habla de la sustitución del PR por estos datos de comportamiento de usuario y donde se cita este estudio de microsoft que también propone mejoras. Google también tiene sus patentes sobre click-through feedback y aquí os dejo la última. Incluso Gary Illyes (Google) confirmó en el último SMX que lo usa como señal de ranking, pero que en ocasiones provoca ruido con lo que se usa en algunos casos. Lo confirmó de nuevo Paul Haahr en 2016.

Manipulación del CTR en el SEO

La manipulación artificial del CTR en el SEO os adelanto desde ya que es una absoluta pérdida de tiempo y si algún día llegase a funcionar sería de forma temporal y para queries poco o nada competidas. Si te crees que se puede manipular a un buscador como Google con el «oye busca esto y clica aquí», «mini jobs» o «pandabots» es que llevas poco tiempo en esto o no te has preocupado de entender la algoritmia detrás de la búsqueda.

Interesante, cuéntame más.

Interesante, cuéntame más.

Razones por las que manipular artificialmente el CTR de un resultado no funciona

- El CTR no es binario: recibir un clic no siempre es bueno y no clicar no siempre es malo. Se usa en combinación con otros datos guardados como el histórico de esa consulta (permanencias en resultado, abandonos de la query, rebotes a la SERP, clics a otros resultados…). La forma de calcularlo es un secreto que guarda cada buscador y este comportamiento tú, «humano o bot», no puedes replicarlo.

- El CTR está sesgado: No solo depende de la posición del resultado, el diseño de la interfaz (configuración de la SERP, dispositivo usado, click bait…) puede variar el resultado ya que no es homogéneo. Este sesgo está corregido por algoritmos muy complejos que tú, «humano o bot», no puedes extrapolar. Pero al final, y a día de hoy, son los evaluadores humanos los que pueden decidir si existe click bait.

- El CTR genera ruido: Tal y como hemos adelantado antes, Gary Illyes dijo que el CTR se usa sólo en algunas ocasiones porque genera ruido. No puedes saber en qué queries, «humano o bot», Google lo usa y cuándo no para calcular los rankings.

- Perfil de usuario: uno de los datos que guardan los buscadores con el click es el perfil del usuario que lo realiza ¿por qué?, porque es una de las maneras que tiene de personalizar resultados para siguientes búsquedas de ese usuario o de usuarios con perfil similar. En el mismo momento que dices a un grupo de amiguetes o red privada que cliquen un resultado, ya has jodido el experimento. Así que tu, «humano o bot», no puedes manipularlo.

- Dwell time: los buscadores saben si un resultado interesa por el CTR, pero luego en función de si un usuario rebota a la SERP y la manera de hacerlo sabe si ese resultado es bueno o no («dwell time»). Esta métrica es clave y es algo que los buscadores intentan arreglar porque es malo para ellos y para los usuarios (por un tema de recursos y porque es un indicador de mala calidad de resultados). Ask ya intentó mitigar este efecto en 2004 sacando una preview de resultados llamada «binocular» y que más adelante sacó Google (¿os acoráis la preview que tenía un bug y duplicaba las visitas en Analytics?). Yahoo también publicó una patente sobre esto en 2008. Entonces, ¿sabes cuál es el tiempo de permanencia que tiene Google como bueno para cada query? Yo tampoco, así que tú, «humano o bot», no puedes saberlo.

- Una URL ≠ una palabra clave: A una URL no solamente se entra por una query (ahora mismo estoy mirando una URL con más de 1000 keywords distintas de entrada). El CTR también se usa como indicador a nivel de URL e incluso de dominio. ¿Eres capaz de simular todo lo anterior y para más de una query? No amigo «humano o bot», no puedes simularlo.

- Intenciones de búsqueda: Los buscadores todavía tienen problemas para identificar la intención detrás de una palabra clave y por eso usan la serendipia y métodos de desambiguación. Esto provoca que la SERP se modifique y una vez más se sesgue el CTR. Además, puede ocurrir que detecte para un resultado tuyo una intención que no es para la que tu intentas aparecer. ¿Eres capaz de conocer la intención que entiende Google para un resultado tuyo? Michael Knight no puede y tú, «humano o bot» tampoco.

- Detección de clics fraudulentos: Google tiene amplia experiencia luchando contra el clic spam. ¿Crees que lo que se aplica con muy buenos resultados en AdWords no se usa para los resultados orgánicos? Si piensas que no entonces tú, «humano o bot», naciste ayer.

- Machine Learning: El CTR y el resto de métricas de usuario se usan dentro de un proceso iterativo de aprendizaje. En el momento en que un resultado deja de clicarse éste se considera poco relevante y se degrada o no en función del resto de resultados. Esto lo hace una vez más por las deficiencias que tiene el PageRank de calcular la relevancia de un resultado. Una URL puede tener mucha autoridad pero no responder al contexto actual de la búsqueda (fecha, dispositivo, ubicación…). El día que seas capaz de manipularlo, ¿podrás hacerlo siempre? Si es así, «humano o bot», dime quien es tu camello porque quiero esa mierda.

Maneras de mejorar el CTR de forma natural

Que el CTR no se pueda manipular artificialmente no quiere decir que no tengas que mejorarlo de forma natural. Sería una estupidez no intentarlo porque es una manera que tienes de conseguir más tráfico, incluso en un mundo en el que Google no lo tuviera en cuenta para rankear.

En enero de 2013 expliqué una parte de un experimento que hice sobre CTR para entender porqué los usuarios hacían click en un resultado y no en otro. De este experimento saqué una lista de factores naturales que pueden impactar en esta métrica:

- Intencionalidad

- Reconocimiento de marca

- Keywords en el title, descripción y url

- Snippets persuasivos y/o con call to action

- Sitelinks

- Rich snippets (rating, breadcrumb…)

Aquí podéis ver un ejemplo de persuasión:

En el ejemplo del tweet, a partir del momento en el que se cambió el title añadiendo el número de elementos que tenía en las categorías de un sitio, el AV Position empieza a subir. ¿Por qué funciona? Las categorías suelen ser un tipo de query más long tail, el efecto del CTR es constante en el tiempo y no solo estoy trabajando una URL, estoy trabajando varias páginas a la vez. Con este simple cambio se pasaron de Top 10 a Top 5 miles de URLs cuyas keywords van de 1K a 22K búsquedas mensuales (en concordancia exacta) con un impacto en tráfico más que considerable. ¿Cuánto tiempo y recursos (amiguetes, dinero en mini jobs, proxys, bots…) podrían llegar a conseguir esto algún día?

Conclusión

Como siempre digo, no pierdas tiempo engañando a los buscadores, gánalo entendiéndolos. Es mucho más productivo y enriquecedor estudiar cómo funcionan los buscadores porque empezarás a remar a favor y no en contra.

Interesante, cuéntame más.

Interesante, cuéntame más.